基于深度学习的多模态AIGC动画探究

时间:2023-06-28 19:20:02 来源:雅意学习网 本文已影响 人

欧阳春雪

四川美术学院,重庆 401331

人工智能 (Artificial Intelligence,AI)是使计算机或机器模拟人类的智慧、能力的一项技术,其作为二十一世纪的尖端技术之一,近三十年取得了迅速发展,早已成为人类现代生活中不可或缺的一部分。

学习能力是人类智慧的核心能力,如表1所示,机器学习(Machine Learning,ML)是一种使计算机具有学习技能的技术,也是使计算机具有人类“智能”的关键。

表1 计算机技术与模拟能力[1]

为了真正模拟人脑学习的复杂神经网络,从机器学习概念中延展出了 “深度学习 (Deep Learning,DL)”。在解决实际问题时,深度学习技术通常与其他技术融会贯通,为AI赋予了更趋自主、更全面的能力。

AI的深度发展与数字内容供给需求的增长使得各个行业的内容生成方式由传统的专业生产内容(Professionally-generated Content,PGC)、用户生成内容(User-generated Content,UGC)转向了人工智能生成内容 (AI-generated Content,AIGC)[2]。

百度创始人兼董事长李彦宏认为:AIGC 已不是单纯用于辅助人类进行内容生产的助手,目前AIGC正处于“协作阶段”,与人类相互配合完成内容生产;

在未来,AIGC将步入 “原创阶段”,能够独立完成内容创作。[3]

2022年8 月,一幅主要使用文本描述生成的AI画作 《太空歌剧院》 (Théâtre D"opéra Spatial)夺得美国科罗拉多州博览会大赛数字艺术类别冠军[4],引起群众对AIGC艺术创作的思考。

而早在2022年7月的戛纳短片电影节(Cannes Short Film Festival),就出现了使用AIGC的动画短片《乌鸦》(TheCrow),将真人舞蹈作品PAINTED 基于 “文本-图像-视频”的多模态转换,以“世界末日中起舞的乌鸦”形象再创作,获得最佳短片奖。

据《AIGC深度产业报告》显示,AIGC未来发展更趋向多模态生成方式,且至2030年,AIGC 市场规模将超万亿人民币。[5]动画作为一门具综合性、商业性的艺术,随着深度学习与多模态AIGC 的引入,传统动画生产方式势必会面临冲击,并迎来新的机遇。

2.1 NLP预训练模型

计算机语言是以 “0”与 “1”组成的二进制,计算机要完成与人进行交互的任务必须通过自然语言处理 (Natural Language Processing,NLP)技术。

Transformer的提出最开始用于机器翻译任务,其基本架构如图 1 所示,Transformer模型的核心自注意力机制 (Self-attention)使得其相对于RNN①和CNN②等传统深度学习网络更擅长处理不同类型的数据,具有更好的并行性与全局性。[6]

图1 Transformer模型架构

NLP的核心是语义理解,为保证计算机能够高效地学习,需要提前建立语义联系,即预训练。通过大量含标签的训练集对文本语句进行向量化表示[7],在下游的具体应用中再对模型进行参数调优,使得模型能更好地匹配任务[8]。

BERT 是典型的一种预训练模型,类似于完形填空,随机遮盖掉部分文本建上下文语义间的联系[9]。

2.2 多模态模型

2019年谷歌发布的VideoBERT 将Transformer拓展到“文本-视频”领域,验证了Transformer预训练用于多模态学习的可行性[10]。

2021年Open AI提出的CLIP 模型基于Transformer进行预训练,分别提取文本与图像的特征并进行对比,得到“文本-图像”的相似度,使得两种不同模态的数据得到关联。[11]

2.3 生成模型

生成模型用于对数据的建模,生成文本、图像、视频等内容,主流的生成模型有生成对抗网络(Generative Adversarial Networks,GAN)和扩散模型(Diffusion Model)。

2.3.1 生成对抗网络

GAN 的框架中含两个模块:生成器 (Generator)和判别器 (Discriminator)。[12]生成器的任务是将输入的初始噪声伪造成一个与真实内容相似的新内容,再由判别器来检验伪造内容的真假,当经过数次对峙训练后,生成内容能够以最大概率“骗”过判别器时,模型则能够生成一张足够“以假乱真”的最优图像。GAN 的基本原理如图 2 所示。

图2 GAN 原理图

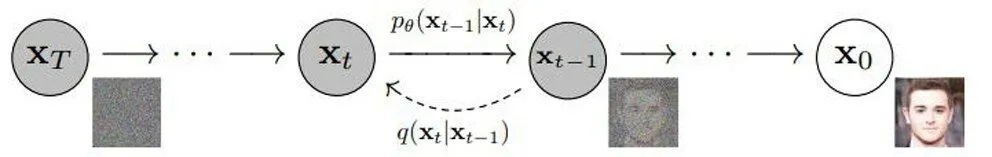

2.3.2 扩散模型

扩散模型正向是不断加噪的过程,逆向是根据不同程度的噪声生成新内容的过程,其原理如图3,扩散模型试图学习噪声分布,其在图片生成任务中的表现超越了GAN[13]。

图3 扩散模型对图形加噪、去噪原理

3.1 图像到动画的生成

视频是连续的图像序列,而动画是以逐格方式拍摄的画面连续播放形成的活动影像。“图像-视频”的跨模态AIGC视频与动画的原理相似,可看作是基于图像的逻辑组合。

由单个图像生成关联图像后进行插帧或者使用扩散模型补充帧数,但在生成动画方面效果存在以下问题:

(1)AI 难以把握无逻辑、主观性语言

由于动画的视觉语言与创作者的主观感受息息相关,根据故事想要传达的内容有不同的表现方式,这样具主观性、非规律性的信息难以对计算机进行学习、训练。

(2)二维图像难以进行三维空间映射

二维动画相对于三维动画更难以让计算机把控摄像机与对象的空间关系,遮挡、透视变换、角度变换会造成 AI 计算错误而导致画面割裂、变形、拖影等[14]。且由于镜头、场景变化多,要得到高准确率的映射需要耗费大量的算力。

(3)运动规律复杂多变

对象的属性、速度影响变形程度,帧数也会影响运动表现的力度,例如表现力度大的动作时会刻意省略帧数,故不是所有运动都适合高帧数的表现方式。

除由图像生成连续画面的视频外,AIGC 还涉及基于二维图像生成三维模型以辅助三维动画创作:

一款用于二次元手绘设定稿动画化的神经渲染器Co NR (Collaborative Neural Rendering)可实现用较少数量的手绘图片映射到A-Pose③下的灰模,导入动作序列即可完成手绘角色模型的三维动画[15]。

谷歌发布的一种端到端的可训练深度神经网络PHORHUM 能够基于单张图像生成三维模型[16],目前尚未开源。新型2D-3D 算法的提出,为三维动画建模提供了便利。

虽然二维图像生成三维模型的技术日益进步,但缺少对动作内容的处理,尚且无法达到依靠硬件设备进行动作捕捉的精度。

3.2 文本到图像的生成

视频内容是图像在时间维度上的叠加,图片生成算法为动画内容的生成奠定了基础。

文本生成图像的热门模型有Midjourney、Disco Diffusion、Stable Diffusion、Dall·E 2等。

其基本原理 (以主流模型为例):CLIP 基于Transformer进行无监督预训练后,会根据扩散模型去噪过程中的图像评估与文本的匹配度,引导扩散模型生成最符合文本的图像。

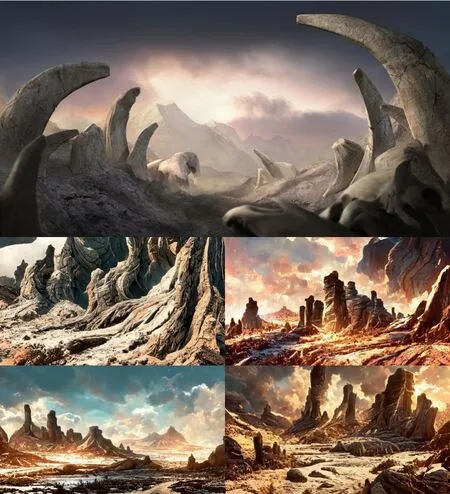

为提高生成图像的准确度,模型往往支持文本描述与图片参考共同作为生成图像的标准 (即 “文本+图像→图像”),图4、图5、图6为使用Midjourney模型生成图像的实例。

图4 文本描述为:“一位美丽的舞者,身穿舞裙,在莫高窟壁画前跳舞。”

图5 文本描述为:“三只剑齿虎,远处是高山,近处是寸草不生的地,地面有堆积的动物骸骨,背光,夕阳下沉,氛围凄凉。”

图6 在图5基础上增加了参考图 (上)生成的4幅图像 (下)

通过在开源模型试验后,总结出AIGC 由文本生成图像的局限性:

(1)AI 生成场景效果普遍优于生成人物

AI 可以模拟细致的颜色、纹理,且场景的排布较人物限制较少,尤其是在远景时,不用考虑过多透视问题。人物在高透视、多遮挡条件下难以生成符合要求的图像,其中正确生成手的拓扑结构是AIGC的难题(图7)。

图7 Novel AI在生成角色时手与身体结构出现偏差

(2)AI 对训练样本少的语义理解不佳

深度学习是建立在大量数据训练基础上的,必然涉及无样本或样本稀缺的类型,无法建立起文本与图像的语义联系。例如,图4-图6中的 “莫高窟”“剑齿虎” “寸草不生”“骸骨”等描述被忽略。而对于“佛跳墙 (Buddha Jumps Over the Wall)”“过桥米线 (Crossing-the-bridge Noodles)”等词在转换为英文时,AI易仅从字面上理解。

(3)需要参考图的辅助才能使得AIGC 更加准确

文本单模态的语义限制不够,越多的描述词延伸的语义也会越多,对于计算机可学习的样本也越多;

相较于描述词限定以外的内容由计算机随机生成来讲,图像可提取的大量特征给了计算机更接近预期的参考。

(4)用户需要经过长时间的熟悉、学习、尝试

基于不同模型的底层代码,用户的操作方式、表述语言都会有所差异。用户使用新模型时需要进行词汇库的积累和学习,了解其工作原理并掌握更加精准的描述词;

由于AIGC 的随机性,每次生成均呈现随机结果,即便使用同样的描述词也会呈现不同的最终图像,需要多次生成尝试后用户自主选择最符合目标的内容;

对于有创作专业基础的用户来说,获得理想图像所消耗的时间成本不一定小于自主创作的时间成本。

3.3 文本到动画的生成

Disco Diffusion在文本跨模态生成多幅图像时,支持将不同描述的图像连接成视频。虽然AIGC 视频内容对画面的衔接平滑流畅,但由于视频生成技术尚不成熟,只能完成推拉、旋转等单一的镜头切换效果,且动画内容会有明显的抖动、变形。

清华大学与智源实验室联合发布的Cog Video是首个开源的文本生成视频模型 (只支持中文输入),直接采用“文本-低帧视频对”来对计算机进行训练,能够生成较为流畅的短视频,其生成案例见图8 。

图8 Cog Video生成的 “文字-视频”案例[17]

谷歌团队连续发布了在视频分辨率、3D 图像生成具有优势的Imagen Video和擅长生成长镜头(长达2分钟以上)讲故事的Phenaki,后者在空间透视关系与合理性方面取得了巨大提升 (图9),但两者尚未开源。

图9 Phenaki在讲述故事时考虑到了反射、交互、遮挡以及场景过渡[18]

虽然基于文本或 “文本+视频”生成视频的AIGC技术在分辨率、流畅性、合理性、故事性各方面都取得了迅速突破,但相较于传统方式拍摄的视频/动画效果还有一定差距。

4.1 技术层面

(1)构建更广的语义网络,应对不同场景的语义偏差

增加AIGC对于上下文及全局的联系,根据语义推断最匹配的理解方式,从而使得AI更易掌握动画视觉语言规律,针对特定事件、背景作出更准确的判断。

(2)以更少的训练样本达成更好的学习效果

提高AI学习效率及迁移运用的能力,减少对监督学习的依赖,降低对训练样本较少的内容的误判率。尤其在“文本-视频”训练样本有限的情况下,高效运用标记信息是AIGC视频的有利支撑。

(3)二维图像到三维模型的映射更加精准

对于空间、深度的映射更为准确,为三维动画模型建模、二维动画摄像机定位创造基础,改善动画主体、镜头运动造成的生成内容变形。

(4)提升系统的抗干扰能力及鲁棒性

增加AIGC对于空间、角度、遮挡、变形的判断力,增加对噪声的抵御力,使得生成内容更趋平滑稳定。

(5)补充常识、逻辑信息

在训练集中引入常识,筛选有效经验作为相关参考,权衡庞大额外数据带来的 “运算效率降低”与“结果逻辑增强”两者的关系。

4.2 内容层面

(1)作为提供创新思路的参考素材

AIGC动画拥有基于大数据样本的优势,生成内容具有各异性、多样性、跳跃性,且数字信息具有便于调整的优势,可辅助创作者寻找创新思路。

(2)作为抽象艺术内容象征

AIGC 动画系统稳定性不足导致画面出现非逻辑性的抖动、变换;

而这样的抽象艺术恰好符合用于刻画意识与梦这样光怪陆离的表现手法,可利用这种性质作为抽象艺术的体现。

(3)作为动画序列帧的初始版本

将AIGC图像作为关键帧,或视频分割为动画序列帧,手动修改不合理、与目标不匹配的部分,保留并提取可借鉴部分,在此基础上进行二次创作。

4.3 市场层面

(1)引入动画制作流程

对于生成文本而言,可服务于编剧;

对于生成图像而言,可服务于概念设计;

对于生成动画而言,可服务于原画师、动画师。AIGC 技术趋于成熟后,有望正式作为动画制作流程的一部分,或增加基于AI 训练、AI 描述的额外岗位。

(2)改变市场供给关系

需求者与创作者身份会相互流通:部分原本不具供给实力的需求方利用 AIGC 转变为内容的提供方,对于部分创作者不善使用AIGC 又渴望尝试,会流向需求一方。

(3)增加岗位对综合性人才的粘性

动画的综合性特征由于人工智能的飞速进步而得到显现,对于岗位人才的能力需求不再是单一能力,而更趋向于综合性方向。

4.4 伦理层面

(1)版权问题

AIGC模型进行学习、训练的样本库来自网络大量的数据信息,生成内容是基于样本信息的再创作。虽然部分模型官方以付费方式出售生成内容的使用版权,但对于样本的原作者是否构成侵权却无法界定。如将AIGC 投入动画生产,需在生成内容上调整修改,不直接套用。

目前国内缺少明文条例用以说明AIGC 的版权问题,依照其快速发展的趋势,可期望于未来完善体制,保障原创者的权益。

(2)安全问题

AIGC追求还原真实性,若被不法分子利用生成违法信息、宣传虚假内容会造成严重后果,模型供应方需对文本敏感词汇进行屏蔽,产出数据需要第三方合理监管、跟踪。

4.5 总结

AIGC的跨模态生成、多模态转换算法真正融入动画产业生产还需克服一定的困难,但随着技术与体制的完善,借助AIGC 赋能动画艺术创作未来可期。

注释

①循环神经网络RNN:全称为Recurrent Neural Network,是一类以序列数据为输入,按链式连接的递归神经网络。

②卷积神经网络CNN:全称为Convolutional Neural Networks,是一类包含卷积计算且具有深度结构的前馈神经网络。

③A-pose:指人物直立,大臂向下30 度的一种标准角色姿势。

猜你喜欢语义模态动画基于BERT-VGG16的多模态情感分析模型成都信息工程大学学报(2022年4期)2022-11-18多模态超声监测DBD移植肾的临床应用昆明医科大学学报(2022年3期)2022-04-19做个动画给你看小哥白尼(趣味科学)(2021年12期)2021-03-16动画发展史小学科学(学生版)(2020年10期)2020-10-28语言与语义开放教育研究(2020年2期)2020-03-31我的动画梦文苑(2019年22期)2019-12-07动画批评融入动画教育的思考新闻传播(2018年3期)2018-05-30“社会”一词的语义流动与新陈代谢中国社会历史评论(2016年2期)2016-06-27车辆CAE分析中自由模态和约束模态的应用与对比广西科技大学学报(2016年1期)2016-06-22“上”与“下”语义的不对称性及其认知阐释现代语文(2016年21期)2016-05-25