基于DiMP模型迁移重组的RGBD目标跟踪

时间:2022-12-03 22:10:02 来源:雅意学习网 本文已影响 人

邱守猛,谷宇章,袁泽强

1.中国科学院 上海微系统与信息技术研究所 仿生视觉系统实验室,上海 200050

2.中国科学院大学,北京 100049

目标跟踪是计算机视觉领域中十分重要的研究方向之一。其在安防监控、人机交互、无人驾驶等诸多领域都有着广阔的应用空间。近些年来,随着深度学习技术的发展与应用,这一领域取得了非常巨大的进步。但是,当前算法的性能与人们的期望仍然存在着一定的差距。深度信息可以提供目标在运动时的三维空间状态信息,对目标状态的估计非常有帮助。但基于深度学习的模型需要大量的数据进行训练,而目前可用于RGBD跟踪器训练的数据集非常缺乏,因此无法直接将深度学习模型应用到RGBD输入下的跟踪任务上来。

目前大多数基于RGBD的目标跟踪算法都是在后期或者逻辑层面上进行融合[1-4],即将RGB图像和深度图分别进行处理并获得对应的结果,然后对两路结果进行融合。或者利用深度信息对RGB支路的跟踪结果进行约束和修正。Wang等人[1]提出了一种融合多种信息的目标跟踪算法,包含了RGB、深度和光流信息。算法使用光流粗略估计目标的位置信息,然后利用RGB和深度信息对目标所在位置进行精确定位。Shi等人[2]提出了一种基于深度梯度信息融合的目标跟踪算法,算法使用深度图的梯度信息对目标的位置进行检测,并最终将检测结果和基于RGB图像上的跟踪结果进行融合。Xiao等人[3]提出了一种双阶段跟踪融合模型,包含了全局匹配模块和局部匹配模块,全局匹配模块同时使用RGB和深度信息对目标进行定位,如果定位结果之间的歧义较大,则使用块匹配方案进行进一步的精确定位。Zhang等人[4]提出了一种实时的基于RGBD信息融合的目标跟踪算法,算法使用两个基于KCF[5]的跟踪器分别在RGB和深度图上进行独立的跟踪,最后通过对两个KCF跟踪器的输出加权获得最终的跟踪结果。

近年来,一些研究者开始尝试将深度学习技术应用到RGBD目标跟踪任务中来。Zhang等人[6]提出了一种基于孪生神经网络遮挡注意的RGBD目标跟踪算法,根据目标区域中深度信息的分布情况来判断是否出现了遮挡。Zhao等人[7]提出了一种基于SiamRPN++[8]的深度信息融合跟踪算法,主要包括掩模生成器和基于深度信息的目标包围框微调模块。其中掩模生成器利用深度信息对目标可能出现的位置进行过滤筛选。基于深度信息的包围框微调模块使用RGB和深度图的融合特征对目标的状态估计结果进行修正,文中使用在RGBD室内分物体割数据集上微调的AlexNet[9]预训练模型提取深度图特征。但由于训练数据集规模的限制,只能使用如AlexNet较浅的网络进行微调,无法有效利用更深网络来进一步提升性能。另外,因为需要对模型重新微调训练,不够灵活。

本文提出一种无需重新微调训练的模型迁移重组算法。通过将不同模型在知识层面进行对齐完成模型间的迁移重组,可以方便地将在其他RGBD任务上训练得到的模型迁移到基于DiMP[10]的跟踪算法上来。对于不同的跟踪对象时,不需要重新计算迁移参数。此外,提出了一种自上而下的深度图平滑算法,可以有效减轻深度图不稳定带来的问题。

本文考虑将在其他RGBD任务上获得的模型迁移到DiMP跟踪器上。DiMP系列目标跟踪算法是目前性能非常优异的算法,算法首先使用高效的判别器进行前背景的分类,完成目标位置的大致定位,接着使用IouNet[11]完成目标包围框的精确回归。算法本身并不针对具体的跟踪对象而训练,因此在跟踪前需要根据跟踪目标进行初始化,非常灵活。而模型初始化时的训练过程可以有效应对迁移融合后特征变化的影响。需要注意的是,本文中的迁移任务和常规的模型迁移问题存在着一定的差异。在本文任务中,已经存在两个在不同域上训练好的网络,算法的目的是将两个模型进行重组利用。下面对本文中提出的算法做具体的介绍。

2.1 模型迁移分析

DiMP模型中使用ResNet[12]作为特征提取网络,这里以常用的ResNet50网络为例进行本文算法的介绍。考虑任意一个在其他RGBD任务上训练得到的模型,其使用网络M作为特征提取网络。由于两者训练时针对的具体任务不同,因此学到的特征表达方式存在差异,无法将在DiMP中训练得到的ResNet50直接替换网络M。但根据卷积神经网络的一般理论,浅层一般提取到的是具有共性的低级特征信息,高层提取到的是具有任务特异性的高级语义信息,因此,如果要利用网络M中提取到的RGBD信息,可以在具有共性信息的浅层上进行迁移。

不失一般性,下面对在ResNet50结构上的第l层和网络M中的第k层上的迁移重组过程进行分析。首先将ResNet50和网络M分别以第l层和k层为分界点,将模型分解为Rb、Rt和Mb、Mt,其中Rb表示l层及以下的部分,Rt表示l层以上的部分,Mb和Mt的含义类似。经过ResNet50的前l层和RGBD网络M的前k层进行特征提取后,得到的特征分别为:

其中,Mf中包含了RGB融合深度后的信息,相比于单独RGB输入下得到的Rf信息更加丰富。但无法直接将该特征输入Rt中进行目标跟踪任务,因为Rf和Mf来自两个不同的网络,其各自对应的训练任务也不同,两者的特征分布模式并不一致。对此,本文考虑设计一迁移函数φ(),通过将迁移函数作用于Rf,使其在特征属性、数值分布上均与Mf保持一致。至此,问题的关键就转化为如何设计有效的转移函数φ()。

2.2 传统算法问题分析

函数φ()的一种实现方案是文献[13]中提出的特征对齐算法。由于该算法与本文提出的算法存在一定的相似之处,因此下面对其进行简要的介绍。假设Mf∈Rcm×hm×wm,Rf∈Rcr×hr×wr。其中cm(cr)表示特征图的通道数,hm(hr)和wm(wr)分别表示特征图的高和宽。在卷积神经网络中,每一通道上的信息是由同一个卷积核在上一层特征图上进行卷积得到的,因此可以被认为包含着同一属性或语义类别的信息。将Mf和Rf在通道维度上进行分解(为了去除特征幅值大小和偏置的影响,这里假设Mf和Rf已经进行均值方差归一化),分别得到:

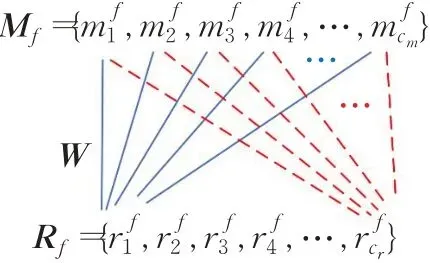

图1 加权重组对齐方案Fig.1 Reorganization alignment algorithm

其中W∈Rcm×cr表示对齐矩阵,对齐后的特征为:

式中*表示矩阵相乘。要使得Rf和Af的分布一致,W可通过下式求得:

但是,上述算法存在一定的问题,由于Mf本身包含的信息比Rf更加丰富,因此上述对齐方式会造成信息的丢失。具体的,考虑图2中出现的情况。

图2 特征属性分布图Fig.2 Feature attribute distribution map

在图2中,假设图(a)和图(b)分别对应从RGB和RGBD中获得的特征信息。并且两路特征在属性上已经进行对齐(横坐标a1,a2,…,an分别表示不同的属性),由于原始输入不同,因此最终得到的特征在不同属性上的信息量分布存在着差异(比如利用深度信息,可以获得更加丰富的物体轮廓信息)。如果直接使用特征对齐的方式进行强制对齐,就会破坏由于增加了深度信息导致的特征在不同属性上信息量分布差异。对于目标跟踪任务,特征迁移和融合的最终目的是通过深度信息来增强特征信息的丰富程度,从而更好地对目标状态进行估计,而不是将特征的分布转化到相同的分布上来,因此文献[13]中的方法与通过融合深度信息来丰富特征的目的是不一致的。

2.3 本文方案

针对传统特征对齐方式存在的问题,本文提出了基于知识对齐的迁移方案,该方法不仅解决了传统方案破坏信息分布的问题,并且计算出的迁移参数具有普适性,因此对于不同的跟踪对象,不需要重新计算迁移参数。

对于卷积神经网络中的不同卷积核,其代表着从数据集中学到的不同的知识,比如对边缘或角点特征的提取。由于模型训练完成后参数就固定下来,因此这一知识非常稳定。此外,不同卷积核只是对应着不同属性的特征,和该属性下特征的分布情况无关(比如当前图像中存在多少边缘信息并不影响边缘提取卷积核的参数),这就很好地解决了图2中存在的问题。基于此,本文提出一种根据模型知识进行特征对齐的算法,假设Rt和Mt中第一层卷积核的参数分别为Wr和Wm,对齐矩阵W计算为:

可以看出,对齐矩阵W不在提取到的特征上进行计算,而是在两个不同网络的权重参数上计算获得。由于网络参数保持不变,因此对齐参数只需要计算一次,对不同的跟踪对象同样适用,实际应用中更加方便。

通过在模型知识上计算对齐矩阵解决了不同模型特征之间的属性匹配问题,但对齐后的特征在数值上的分布可能并不一致。为解决这一问题,这里考虑数值分布的两个常用指标,均值和方差。因此特征的数值分布对齐算法非常简单,记Rf中每一通道的均值和方差分别为,特征加权重组后的Af中每一通道的均值和方差分别为。特征分布自适应算法计算如下:

可以看出,上式的运算和神经网络中BN(batch normalization)的计算方式十分相似,不同之处在于上式中的均值和方差是根据利用Rf和Af共同计算获得。但仅使用某一输入下的Rf和Af信息不具有代表性,进一步,考虑到本文进行迁移的网络在输出之前都经过BN层,因此这里的均值和方差可以利用l层和k层中BN层中的均值和方差参数。即当网络层中存在BN层时,特征分布自适应的计算过程如下:

记网络M第k层中通道间的相关性矩阵为Ψ:

其中cij,i,j∈{1,2,…,cm}的计算不是通过计算不同通道之间特征图的相关性获得的,而是通过计算生成特征图的卷积核之间的相关性获得的,由上面的分析可知,基于卷积核(知识)的计算结果更加准确和稳定。对于生成特征图的卷积核wi和wj,其相关性计算为:

V*的正确计算公式为:

至此,两个模型不同层之间的特征迁移完成。

2.4 深度图预处理

与RGB图像不同,由于获取方式和技术的原因,深度图中会存在大量的不准确值,这在物体的轮廓处尤其明显。另外,相邻帧之间的深度信息不够稳定,如图3所示。特征的不稳定会对跟踪器的性能产生重要影响。对此,本文提出一种简单高效的深度图平滑稳定算法,可以有效抑制异常值带来的干扰,并同时增强相邻帧之间深度图的连续性。

图3 深度图预处理Fig.3 Depth map preprocessing

考虑到现实场景中物体的深度具有一定的连续性,实际处理中并不需要十分精确的深度信息,本文首先将原始深度图像D进行下采样得到Dd,以加快处理速度。为了抑制图中的异常值,对下采样后的图像进行平滑滤波,得到图像,这里选用简单的均值滤波。然后根据与Dd之间的差异计算对异常值的抑制矩阵:

其中,δ为控制抑制程度的超参数。用上式中得到的抑制矩阵对Dd中的像素进行加权滤波,最后将图像上采样到原图大小。通过图3可以看出(第一行为未经处理的深度图,第二行为平滑后的深度图,视频序列选取VOTRGBD数据集[14]中的box_darkroom_noocc_6序列),经过本文平滑算法处理后的深度图相邻帧之间的不稳定峰值噪声从4 000左右降低至400左右,下降了一个数量级。

本文提出的算法整体结构如图4所示。

图4 本文算法整体流程图Fig.4 Algorithm flow chart of this article

3.1 实验环境及参数设定

本文算法运行平台配置:CPU为8核3.00 GHzi7-9700,内存16 GB,显卡为RTX2060,操作系统为Ubuntu 18.04,编程环境为Python3.6。本文选择对两个不同的RGBD网络进行迁移,以验证算法的有效性。跟踪模型选择DiMP50,其他RGBD任务上的模型分别选择用于室内物体分割的RedNet[15]和ACNet[16]。上述三个模型都使用ResNet50作为Backbone进行特征提取。由于训练任务的不同,只使用迁移后的特征不能够满足跟踪任务的需要。对此,本文将迁移后的特征作为RGB特征的补充,将迁移后的特征和原来的RGB特征进行简单的线性加权融合:

其中,frgbd表示最终的融合特征,η表示融合系数。

特征迁移时,选择在网络的哪一层进行迁移非常重要。对此,这里将ResNet50按照Block进行分块,对不同Block后进行迁移的效果进行了实验。如图5所示,从左至右(a)、(b)、(c)分别表示从ResNet50的第一个Block前、第二个Block前和第三个Block前进行迁移(融合系数选取一致,设置为0.3),由于Block的第一层为起到维度升降作用的1×1卷积层,只涉及到特征的融合重组,并不涉及特征提取,因此,具体迁移时是在后面卷积核大小为3×3的卷积层。其中红色标注表示响应图上的最大响应值(在相同的初始化条件下,认为其可以表示特征的可判别性)。可以看出,当迁移层数过浅时(图(a)),由于深度信息还没有经过RGBD网络充分的融合和处理,所以最大响应值低于在第二个Block层前进行迁移。当迁移层数过深时(图(c)),由于涉及到了具体任务相关的信息,而这可能与跟踪任务不适配,因此响应效果也低于在第二个Block层前进行迁移。进一步的,对整个数据集中所有视频序列的第一帧判别性进行了统计(对第一帧的判别器响应图记录其峰值信息并求平均),并与文献[12]中的方法进行了对比,结果如表1所示。

图5 不同Block层迁移下的第一帧判别器响应图(boxes_humans_room_occ_1序列)Fig.5 Response map at first frame under different block layer transfer learning

表1 不同Block层迁移下判别性统计信息Table 1 Distinguish statistical under different block transfer

通过表1中的结果可以看出,由于SA[13]特征对齐算法只是让特征分布趋于一致,并没有充分利用到深度图带来的额外信息,而本文算法在迁移时则充分提取了所有属性的信息。所以,融合后的效果要优于SA中的特征对齐方案。

因此,本文选择在ResNet50的第一个Block结束后进行迁移。实验中,融合系数取0.3。

3.2 实验数据集介绍

为验证本文提出算法的有效性,算法在VOT目标竞赛中使用的RGBD数据集上进行验证。VOTRGBD数据集中一共包含80个不同的视频序列,视频中的所有RGB和深度图像都进行了对齐。为了考察跟踪器在不同使用不同方式获取的深度图下的泛化能力。其中12个视频的深度信息是通过Kinect相机采集获得的,58个视频中的深度图是通过TOF(飞行时间技术)技术获得,剩下的10个视频序列中的深度信息是通过双目立体视觉来获得。因此与其他RGBD数据集相比,该数据集更能有效衡量跟踪器在不同深度信息输入下的泛化能力。该数据集上使用的评价指标为Pr、Re和F。其中Pr是准确率,Re表示召回率,F是考虑到准确率和召回率的综合指标,其中Pr的计算方式如下:

其中:

式中,Gt表示目标状态的真值,At(τθ)是跟踪器预测的结果,t表示当前的时间帧下,τθ是跟踪器对结果的置信度,Np表示预测结果不为空的视频帧数,即At(τθ)≠∅。Ω(At(τθ),Gt)表示预测结果和真值之间的交并比,计算公式如下:

Re的计算方式如下:

其中:

式中,Ng表示视频中不存在目标的帧数,即Gt≠∅。

F的计算方式为:

由于不同的τθ下计算得到的F指标会存在差异,为了避免这一参数变化带来的影响,计算F指标时会自动寻找可以最大化F指标的τθ,并将此时的F值作为最终指标。

3.3 结果与分析

本文算法在VOTRGBD数据集上和多种先进的跟踪算法进行比较,如AlphaRef[20]、OceanPlus[21]、RPT[22]等。表2为不同算法在VOTRGBD数据集上的跟踪性能表现,可以看出,在融合RedNet模型提取的深度特征后,跟踪性能在Pr、F指标上分别提升了11.5%和2.6%,在Re指标上有所下降。在融合ACNet模型提取的深度特征后,跟踪性能在Pr、Re、F指标上分别提升了3.0%、1.9%和2.6%。

表2 在VOTRGBD数据集上的实验结果Table 2 Experimental results on VOTRGBD dataset

为了更加直观地分析融合深度信息前后(融合模型为RedNet)跟踪算法在一些具体视频序列上的性能变化情况,接下来对部分视频序列上的跟踪结果进行可视化分析,结果如图6所示。可以看出,在跟踪过程中,当在RGB信息中目标和背景比较相似(如图6(a)bag_outside),或者光照条件比较暗时(如图6(b)box_darkroom_noocc_1、(c)box_darkroom_noocc_3),当背景颜色和目标颜色相近时,只用RGB信息很难定位到目标的具体轮廓信息。而由于深度信息不受光照变化的影响,因此该情境下可以对目标定位提供非常重要的帮助。另外,当目标发生较大的外观变化时(图6(d)boxes_humans_room_occ_1),跟踪器如果无法快速适应变化后的目标,就会跟踪失败,但是如果这时目标没有发生快速的运动,其深度信息依然是相对稳定的,因此根据深度信息依然可以有效地对目标进行跟踪。

图6 在数据集VOTRGBD上的定性评测结果Fig.6 Qualitative evaluation results on VOTRGBD dataset

3.4 消融实验

表3中通过比较使用深度图预处理前后(+D表示直接使用深度图,+D+P表示使用了本文提出的深度图平滑处理算法)的跟踪性能可以看出,对深度图进行预处理后,跟踪性能有了进一步的明显提升,在F指标上相较于基础算法提升了2.6%,相较于不使用深度图预处理的改进后算法提升了1.6%。在Pr指标上相较于基础算法提升了11.4%,相较于不使用深度图预处理的改进后算法提升了9.5%。对于Re指标,使用深度信息后有所下降,这是因为在单独RGB图像输入时,目标的外观特征在一定时间内具有一定的连续性,当因为遮挡等问题暂时造成目标丢失时,后面有一定的概率可以恢复。但当RGB和深度信息同时输入时,目标定位错误时的深度信息可能和真实的目标深度存在着较大的差别,不利于后续跟踪的恢复。

表3 在VOTRGBD数据集上的消融实验Table 3 Ablation study on VOTRGBD dataset

本文提出一种基于模型迁移重组的深度信息融合目标跟踪算法,解决了当前由于RGBD跟踪数据集缺乏,无法有效训练基于RGBD的深度学习目标跟踪器的问题。相比于传统基于特征的迁移方法更加稳定高效。此外,提出了一种高效的深度图平滑算法,降低了深度图中异常值的干扰。在VOTRGBD数据集上的实验结果表明,使用本文提出的迁移融合算法后,可以丰富特征信息,提升目标和背景信息的判别性,最终提高跟踪性能。但是,不同情景下深度信息对跟踪器的作用应该是不同的,如何在算法中考虑这一因素将会是接下来的研究方向。

猜你喜欢 卷积深度算法 基于全卷积神经网络的猪背膘厚快速准确测定农业工程学报(2022年12期)2022-09-09基于FPGA的卷积神经网络加速优化方法计算机仿真(2022年7期)2022-08-22四增四减 深度推进快乐学习报·教育周刊(2022年16期)2022-05-01深度思考之不等式新高考·高三数学(2022年3期)2022-04-28基于图像处理与卷积神经网络的零件识别计算技术与自动化(2022年1期)2022-04-15基于深度卷积网络与空洞卷积融合的人群计数上海师范大学学报·自然科学版(2019年5期)2019-12-13Travellng thg World Full—time for Rree阅读与作文(英语初中版)(2019年8期)2019-08-27简约教学 深度学习福建基础教育研究(2019年6期)2019-05-28学习算法的“三种境界”中学生数理化·高一版(2017年1期)2017-04-25算法框图的补全中学生数理化·高一版(2017年1期)2017-04-25