基于梯度相似性的自动作文评分多主题联合预训练方法

时间:2022-12-05 20:05:03 来源:雅意学习网 本文已影响 人

李晨亮,吴鸿涛

(1. 武汉大学空天信息安全与可信计算教育部重点实验室 武汉 430072;

2. 武汉大学国家网络安全学院 武汉 430072)

自动作文评分(automated essay scoring, AES)是自然语言处理领域的一项重要任务,目标是采用自动化的方法来评估作文的写作质量并给作文评分。自动作文评分系统在教育领域有着广阔的应用前景,如托福考试的写作题判卷就使用了机器判卷系统E-rater[1]。最早的AES 系统可以追溯到1966年开发的Project Essay Grader 系统[2],并在此后一直备受关注。早期的AES 系统主要依赖手工提取的特征,包括长度特征、词汇特征、句法特征及语义特征等类别。然而,手工提取特征费时费力,还可能需要专家的参与。

随着深度学习技术的兴起,目前主流的AES系统大多是基于深度神经网络,或者神经网络与特征工程相结合的方式来实现。文献[3]最早尝试使用神经网络来构建AES 系统,通过卷积神经网络(convolutional neural network, CNN)和循环神经网络(recurrent neural network, RNN)来学习作文的向量表征,再使用全连接层来预测作文分数。文献[4]对作文的层次结构进行建模,分别使用一个单词级的CNN+池化层来学习句子表示,以及一个句子级的CNN+池化层用于根据句子表示来学习全文的表示。文献[5]在文献[4]的基础上引入了注意力机制,来区分不同词和不同句子的重要性,并且通过实验证明CNN 更适合对句子建模,RNN 更适合对全文建模。文献[6]从词向量入手,首先在C&W词向量模型[7]的基础上增加作文评分任务来学习任务增强的词向量,然后将训练好的词向量输入两层双向LSTM 网络[8]学习预测作文分数。文献[9]使用神经张量网络对LSTM 不同时间步的隐状态向量之间的关系进行建模,以提升对作文连贯性的表达能力。以上工作都是将作文评分任务视为一个回归任务,损失函数为模型预测分数和人工标注分数之间的均方误差(mean-square error, MSE)。文献[10]将自动作文评分看作一项分类任务,使用强化学习来解决,将模型与人工专家评分之间的kappa 一致性系数作为agent 的奖励值。最新的工作开始在作文评分任务中应用大规模预训练语言模型(如BERT[11])。文献[12]将特征工程与BERT 相结合用于作文评分,使用长度特征、句法特征、词语特征和可读性特征4 类特征,将特征向量与神经网络模型输出的作文向量拼接后输入全连接层预测分数。文献[13]提出了一个基于BERT 的AES 方法,将作文评分同时视为回归任务和排序任务,使用一个随训练过程动态调整的权重来平衡回归损失和排序损失。大规模预训练语言模型的应用已经将评分准确性提升到更高的水平。

基于神经网络的模型摆脱了对手工设计特征的依赖。然而,深层神经网络需要大量数据来训练才能发挥其强大的学习能力。但是,自动作文评分任务面临较严重的数据不足的问题,因为现有的AES数据集由多个主题(即题目)组成,每个主题下只有较少量的样本。目前的AES 方法大多是单独考虑一个主题的,即分别用每个主题的训练数据训练一个模型,该模型只用于对该主题的作文进行评分。这些方法只使用目标主题的少量训练样本,而不利用剩余其他主题的样本。本文通过实验证明,引入外部主题的样本来增加训练数据量能进一步提升模型的表现。考虑到不同主题之间存在差异,直接加入其他主题的训练样本,训练模型会引入训练噪声,为此本文提出了一种基于梯度相似性的自动加权方法。该方法的训练包含预训练和微调两个阶段。在预训练阶段,同时使用多个主题的作文数据来训练模型。对于其他主题的训练样本,计算该样本的梯度向量与目标主题的梯度向量之间的相似度作为该样本的损失权重。在微调阶段,使用目标主题的训练数据来微调模型。最后,将训练好的模型用于对目标主题的测试样本进行评分。相比于传统的单主题AES 方法,本文方法引入了其他主题的训练样本,有效缓解了数据不足的问题,并且基于梯度相似性进行加权,降低了直接使用其他领域的样本带来的训练噪声。此外,本文还将神经网络与特征工程相结合,手工设计了3 类特征,进一步提升了模型的评分表现。在公开数据集上进行的对比实验表明,与传统的基于单主题样本的方法相比,本文提出的多主题联合预训练方法能有效提升AES 模型的评分准确性,结合特征工程后能实现进一步的提升。

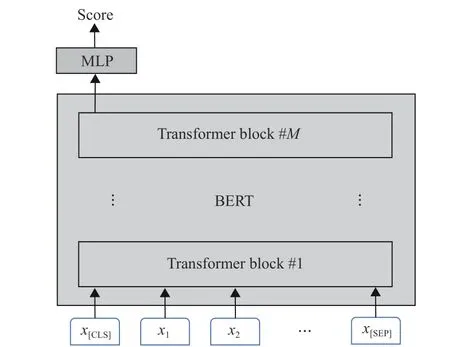

1.1 作文评分模型

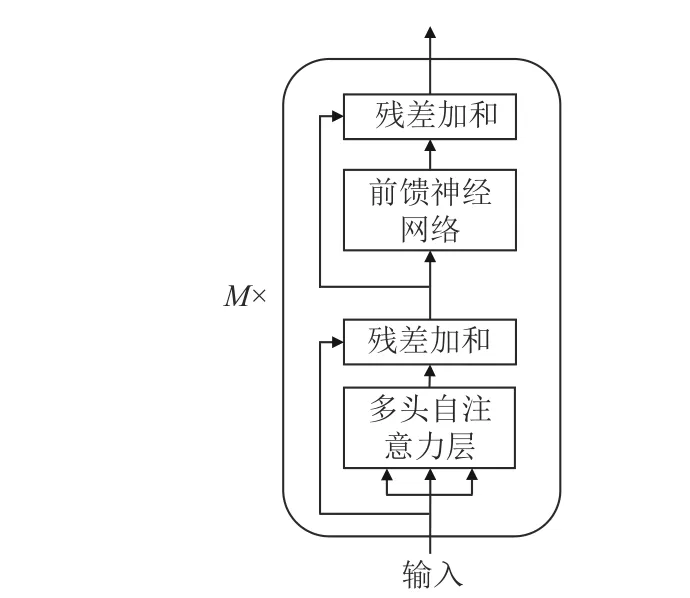

本文模型基于预训练BERT 实现,模型结构如图1 所示。BERT 是由谷歌提出的大规模预训练语言模型,基于Transformer 网络实现[14],由多个Transformer 编码器层堆叠组成。每个Transformer层包含一个多头自注意力模块和前馈神经网络,并且使用残差连接[15]将输入和输出结合。Transformer的这种结构能有效抽取文本的特征表示,因此在自然语言处理领域得到广泛应用。原始的BERT 分为BERT-base 和BERT-large 两个版本,base 版本包含12 个Transformer 编码器层,每层的注意力头数为12 个,总的参数量约1.1 亿。本文采用BERT-base来构建作文评分模型。

图1 作文评分模型结构

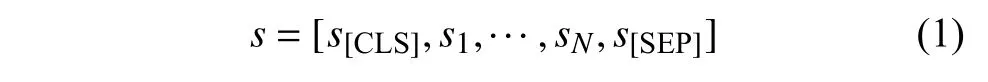

给定一篇作文s,首先通过BERT 的分词器将其转化为子词(sub-token)序列,并在序列开头和结尾分别插入“[CLS]”和“[SEP]”两个特殊词:

然后通过词向量层转换为词向量序列:

再将x输入到Transformer 编码器层。每个编码器层由一个多头自注意力模块和一个前馈神经网络组成,如图2 所示。

图2 Transformer 编码器结构

多头自注意力模块将输入的向量序列组成的矩阵X∈RL×d(L是 序列长度,d是向量维度)映射到多个不同的语义空间进行自注意力操作,抽取不同方面的语义特征。对于每个自注意力头,首先将X分别经过3 个不同的线性变换得到Q、K、V这3 个矩阵,然后计算自注意力头的输出:

式中,h=12是 注意力头的数量;

QKT∈RL×L计算每个词对序列中所有词的注意力分数;

使用softmax(·)函数将注意力分数归一化为权重,再将注意力权重乘上V得到自注意力模块的输出。

然后,将12 个自注意力头的输出拼接后再经过一层线性变换得到多头自注意力层的最终输出:

式中,Wl和bl是参数矩阵和偏置向量。

然后通过残差连接将Z与X相加,再进行层归一化操作。将结果输入到后面的全连接前馈神经网络F FN中。FFN 具有相同的残差连接和层归一化机制,FFN 的最终输出将传递给下一个编码器模块。

经过M=12个编码器模块后,BERT 输出一个隐状态向量序列:

最后,r=h[CLS]被 用作作文的表示向量。将r与通过特征工程抽取的人工特征向量f(将在下一节介绍)拼接后输入预测层(两层的全连接网络),然后输出最终的预测分数:

式中, σ是sigmoid 激活函数;

yˆ ∈(0,1)。在模型的推理阶段,将yˆ缩放到作文的分数区间即得到预测的作文分数。

式中,m是一批样本的样本数。

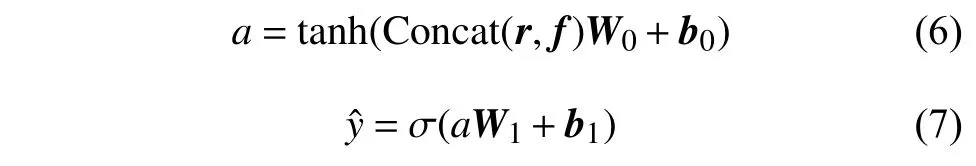

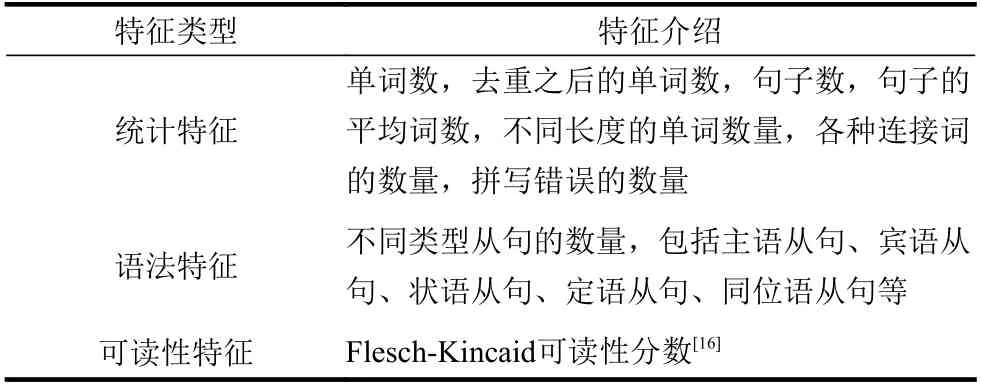

1.2 特征工程

为了进一步增强作文评分的准确性和可解释性,本文将神经网络与手工设计的特征相结合,设计了3 类特征,如表1 所示。其中,Flesch-Kincaid(FK)可读性分数是衡量文章是否易于理解的指标,包括FK 可读性分数(Flesch-Kincaid reading ease formula)和FK 可读性年级水平(Flesch-Kincaid grade level formula)两个指标。FK 可读性分数(s)和FK 年级水平(g)的计算公式分别为:

表1 手工设计的特征

式中,a和b分别指该文章中句子的平均词数以及单词的平均音节数;

FK 可读性分数在0~100 之间,分数越高表示文章越容易理解。一般来说,分数在60 分以上即可视为可读性较好。FK 年级水平反映的是要能理解这篇文章至少需要达到的美国学校年级。FK 年级水平越高,说明文章更难理解。

将抽取的特征值按照最小−最大归一化方法缩放为介于[0,1]的值,然后将所有特征拼接为一个特征向量f,与神经网络抽取的表示向量r拼接后输入到预测层预测分数。

1.3 多主题联合预训练

公开的作文评分数据集由多个主题构成,每个主题下平均只有大约一千篇作文,这样的数据量用来训练深层神经网络模型容易造成过拟合,限制了模型的泛化能力。为此,本文提出一种基于梯度相似性来自动加权的多主题联合预训练的方法。模型的训练分为两个阶段:预训练和微调阶段。在预训练阶段,使用所有主题的全部训练样本来训练模型;

在微调阶段,只使用目标主题的样本来对模型进行精调训练。

假设作文评分数据集D一共有n个主题,现在需要训练一个模型用于对其中一个主题的作文进行评分,称该主题为目标主题。将目标主题的训练集记为Dt, 其他主题组成的混合训练集记为Do。

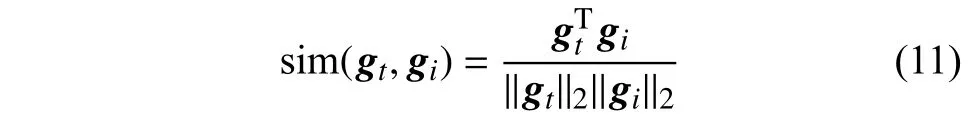

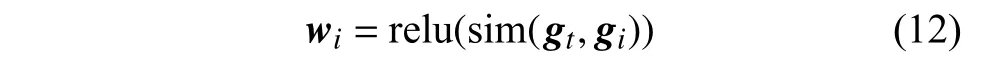

考虑到不同主题之间存在差异,直接使用其他主题的训练样本未必能获得较大收益。本文提出根据梯度相似性来对其他主题的样本进行加权。首先根据式(8)计算目标主题的样本的平均损失Lt,然后计算Lt对 模型参数 θ 的梯度向量gt=∇θLt,将其称为标准梯度。然后对一个来自其他主题的训练样本bi计 算其损失Li, 并求梯度向量gi=∇θLi。由于梯度向量反映了模型优化的方向,本文假设,如果一个样本产生的梯度方向与标准梯度方向越接近,则该样本与目标主题越“接近”,或者说产生的优化效果与目标主题的样本产生的效果越相似。于是,计算gi和gt之间的余弦相似度:

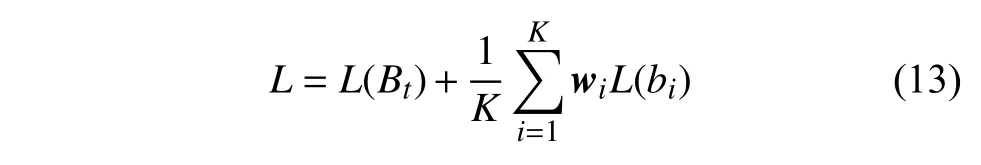

如果 sim(gt,gi)>0,则认为该样本对模型优化有一定的正面效果,将s im(gt,gi)作为该样本的损失权重。于是,第i个其他主题的样本的权重为:完整的训练过程如下:

1) 从Dt、Do中 分别采样一批样本记为Bt、Bo;

2) 根据式(8)计算Bt的平均损失L(Bt),并求得其梯度向量gt;

3) 对Bo中 的每个样本bi, 计算对应损失L(bi),并求梯度向量gi, 根据式(12)求得权重wi;

4) 按下式计算总的损失,并更新模型参数

5) 重复前4 步直至训练收敛。

预训练完成后,再用目标主题的样本对模型微调训练,然后在目标主题测试集上评估模型表现。

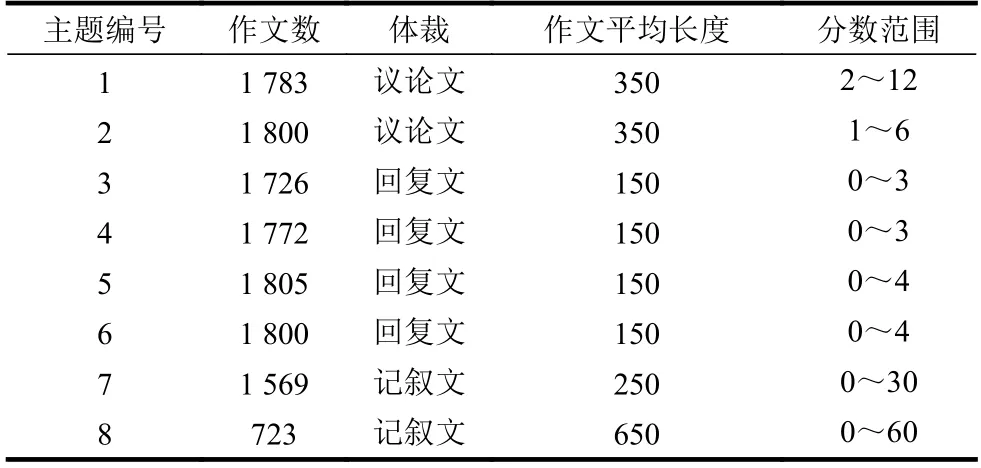

2.1 数据集

本文在ASAP 作文评分数据集(https://www.kaggle.com/c/asap-aes/data)上进行实验。ASAP 数据集是目前公开的最大、最常用的作文评分数据集,被广泛用于评测AES 模型的评分准确性。ASAP 数据集由8 个主题的子集构成,包含3 种作文体裁:记叙文、议论文和回复类作文。数据集的统计结果如表2 所示。

表2 ASAP 数据集的统计结果

2.2 基线模型和评估指标

本文比较了以下主流的基线方法:1) EASE;

2) LSTM、 BiLSTM;

3) CNN-LSTM[3];

4) NNLSTM-Att[5];

5) RL1[10];

6) SKIPFLOW[9];

7) HISK+BOSWE[17];

8) R2BERT[13];

9) BERT。

其中,1)和7)是传统统计学习方法,其余是神经网络模型。EASE 是一个开源的作文评分系统(https://github.com/edx/ease),使用手工设计的特征(如长度特征、词袋特征等)来训练机器学习算法,如SVM,进行评分预测。HISK+BOSWE 分别使用直方图相交字符串核(histogram intersection string kernel, HISK)和BOSWE 词向量来构造核矩阵,并将两个核矩阵结合后训练一个ν-SVR 模型;

LSTM、BiLSTM 表示分别训练一个两层的LSTM和双向的LSTM,并且将所有隐向量进行平均池化作为作文表示;

CNN-LSTM 使用CNN 来抽取句内的词组特征,用LSTM 建模句子间的语义关联特征;

CNN-LSTM-Att 在CNN-LSTM 的基础上引入了注意力机制;

SKIPFLOW 在学习作文表示的同时显式地加入了对连贯性的建模;

RL1 是基于强化学习的AES 模型,使用Dilated LSTM[18]网络来抽取作文的表示并执行决策,使用策略梯度直接优化QWK 指标;

BERT 是本文方法的基础版本,与本文模型的区别在于:没有使用特征工程,没有使用其他主题的作文数据;

R2BERT 是文献[13]提出的基于BERT 的AES 模型,同时优化回归损失(MSE 损失)和排序损失(list-wise 排序损失),是目前最强的AES 神经网络模型。

与其他相关工作一样,本文使用Quadratic Weighted Kappa (QWK)系数作为模型评分准确性的衡量指标。QWK 系数用于衡量两组评分(机器评分和人工评分)之间的一致性,取值通常介于0~1 之间,分数越高表示一致性越高。如果小于0,说明一致性甚至不如随机评分。QWK 的计算可以参考文献[10,13]。

2.3 实现细节

本文的模型使用Python 语言和Pytorch 框架实现,预训练BERT 采用HuggingFace 发布的“bertbase-uncased”模型。在预训练阶段,初始学习率设为4×10−5,使用Adam 优化器,训练50 轮,取验证集上结果最好的模型用于微调。在微调阶段,初始学习率设为3×10−6,仍使用Adam 优化器,训练30 轮。对于超出BERT 长度限制的作文,将超出长度限制的部分裁减掉。由于每个主题的样本数较少,因此本文采用5-折交叉验证方法,每折按照3:1:1 的比例划分训练集、验证集、测试集。将5 个测试集的结果求平均作为最终结果。

2.4 实验结果

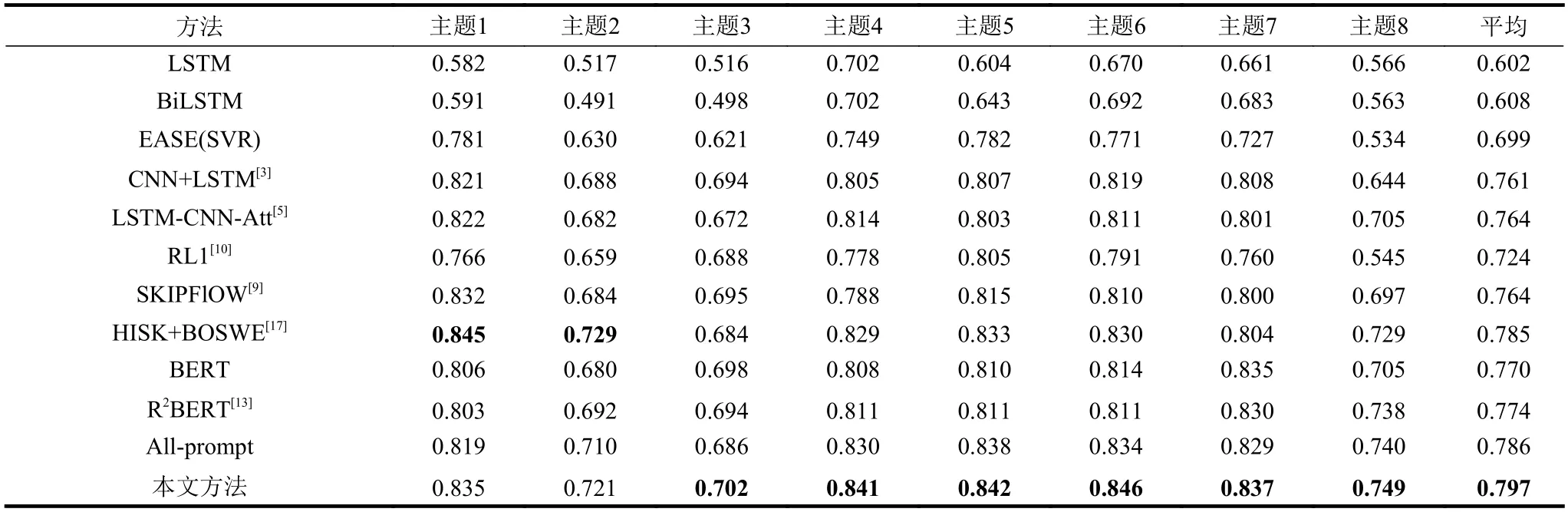

表3 列出了不同模型在ASAP 数据集的8 个主题上的QWK 分数,粗体字表示最优结果。

表3 不同方法在ASAP 数据集的8 个主题上的结果

从结果来看,BiLSTM 优于LSTM,这是符合直觉的,因为BiLSTM 能够捕捉更全面的上下文信息。EASE 的表现优于LSTM 和BiLSTM 这两个神经网络模型,说明简单的神经网络结构未必比使用精心设计的手工特征来训练传统机器学习算法的效果更好。CNN-LSTM 的表现相比单纯使用LSTM的方法有较大提升,这主要是由于LSTM、BiLSTM这两个基线模型直接将整篇作文作为一个长序列,而忽视了句子级的结构信息,且LSTM 不适合捕捉长距离依赖信息,在长文本的表现较差。而CNN-LSTM 是先用CNN 来学习句子的向量表示,再用LSTM 来学习全文的表示,这种建模方式考虑了文章的层次结构,保留了句子级的结构信息,且CNN 天然适合学习相邻词之间的关联特征,更适合对句子语义建模[5]。CNN-LSTM-Att 在CNNLSTM 的基础上引入了注意力机制,使评分准确性获得进一步提升。注意力机制能区分不同词和不同句子的重要性,能够关注到更重要的局部特征,是目前的神经网络模型的基础结构。RL1 使用强化学习的方法来直接优化QWK 指标,但结果并不是特别优异,这跟它也是使用简单的LSTM 网络来学习文章表示有关。SKIPFlOW 通过增加前后句子间连贯性进行建模,获得了进一步的表现提升,这说明对于AES 任务来说,评估文章的连贯性也很重要。基于核方法的HISK+BOSWE 超越了所有神经网络基线模型,尤其是在议论文体裁的主题1 和主题2 上仍保持目前最优秀的性能,这也说明传统的机器学习方法的潜力不应被低估。而BERT、R2BERT这两个基于预训练BERT 的模型并未取得最好的基线模型结果,这可能是由于数据量太小,容易导致过拟合,限制了大模型的学习能力。本文方法在6 个主题上都取得了最优结果,说明了本文提出的特征工程和多主题联合预训练的方法的有效性。All-prompt 是本文方法的基线版本,与本文方法的区别在于,没有使用基于梯度相似性的加权方法,而是直接将其他主题的数据加到训练集中。由结果可知,使用本文的损失加权方案可以在引入外部主题数据的同时,降低跟目标主题差异较大的样本的权重,进一步提升模型表现。

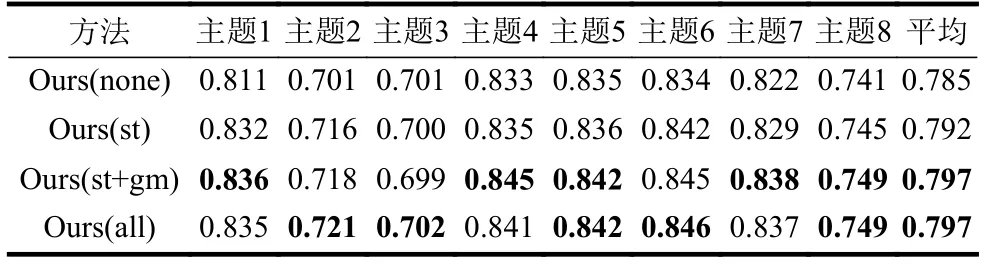

2.5 消融实验

为了验证本文设计的3 类特征的效果,本文通过实验比较了不使用人工特征(none)、只使用统计特征(st)、使用统计特征+语法特征(st+gm)和使用所有特征的结果(all)。结果如表4 所示,粗体字表示最优结果。

表4 比较使用不同特征的结果

从结果可知,统计类特征和语法类特征均对提升评分准确性有帮助,尤其是在议论文体裁的主题1 和主题2 上提升更加显著。这说明在当今深度神经网络成为主流机器学习方法的时期,考虑融合传统人工设计的特征对提升模型表现仍可能是有帮助的。加入可读性特征尽管未获得明显提升,但也不能说明不需要考虑作文的可读性,这也可能是使用的可读性特征不能很好反映文章是否易于理解,未来可以尝试设计更有效的可读性特征。

针对自动作文评分领域当前面临的训练数据不足的问题,本文提出了一种多主题联合预训练方法,通过引入外部主题的作文数据,增加了训练样本的数量。为了降低直接引入差异较大的外部主题的样本带来的训练噪声,本文提出了一种基于梯度相似性的损失重加权方案。此外,为了进一步提升深度学习模型的性能,本文还将深度学习与传统特征工程相结合,并设计了3 类作文特征。在公开数据集上的实验结果表明,本文方法显著优于传统的单主题内训练方法。

进一步的工作可以考虑以下3 个方向:1) 多维度质量评分。现有的AES 方法绝大多数都是对作文质量进行整体评分,而很少关注作文质量的不同维度。文献[19]列举了作文质量的不同方面,包括语法、遣词、标点、组织结构、连贯性、说服力等11 个方面。研究从不同维度对作文质量进行评分能够给用户提供更详细的信息,使用户知晓作文的不足之处。2) 评分反馈。现有的AES 方法都只能对作文评分,而无法提供类似教师评语的反馈,如果能生成对应的反馈意见将有助于帮助学生提高写作水平。3) 少样本学习。由于AES 领域缺少大规模数据集,因此可以研究少样本学习的方法,减轻对监督数据的依赖。

猜你喜欢 向量神经网络样本 基于神经网络的船舶电力系统故障诊断方法舰船科学技术(2022年11期)2022-07-15向量的分解新高考·高一数学(2022年3期)2022-04-28MIV-PSO-BP神经网络用户热负荷预测煤气与热力(2022年2期)2022-03-09基于改进Hopfield神经网络的对地攻击型无人机自主能力评价北京航空航天大学学报(2021年4期)2021-11-24聚焦“向量与三角”创新题中学生数理化(高中版.高考数学)(2021年1期)2021-03-19规划·样本领导决策信息(2018年16期)2018-09-27人大专题询问之“方城样本”人大建设(2017年10期)2018-01-23三次样条和二次删除相辅助的WASD神经网络与日本人口预测软件(2017年6期)2017-09-23随机微分方程的样本Lyapunov二次型估计数学学习与研究(2017年3期)2017-03-09向量垂直在解析几何中的应用高中生学习·高三版(2016年9期)2016-05-14